Postacie NPC bardziej jak „żywe” dzięki AI

Podczas ostatniej konferencji Game Developers Conference NVIDIA zaprezentowała fascynujące możliwości wykorzystania narzędzi sztucznej inteligencji „cyfrowego człowieka” w grach wideo, szczególnie w kontekście podkładania głosu, animacji i generowania dialogów dla postaci niezależnych (NPC). W pokazanym fragmencie z grywalnego demo technologicznego „Covert Protocol” gracze mogą doświadczyć, jak postacie oparte na sztucznej inteligencji reagują na interakcje w unikalny sposób, tworząc odpowiedzi pasujące do bieżącej rozgrywki. NVIDIA twierdzi, że dzięki jej technologii, każda sesja gry jest wyjątkowa, co otwiera drzwi do tworzenia bardziej dynamicznych i interaktywnych doświadczeń w wirtualnych światach.

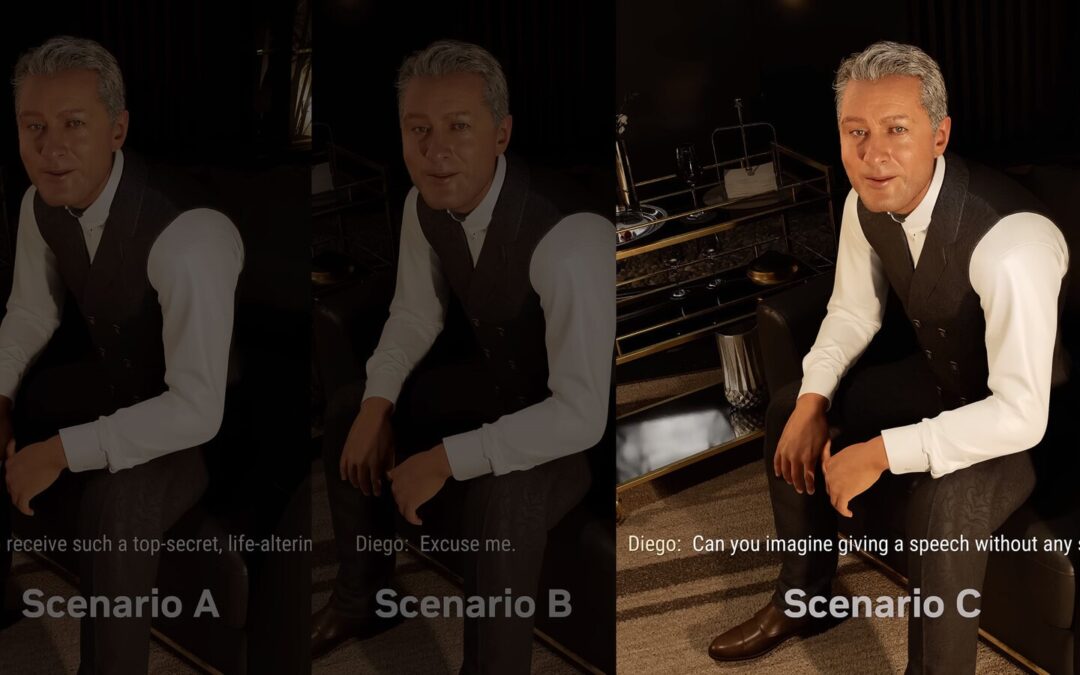

Demonstracja „Covert Protocol”, stworzona we współpracy z Inworld AI, wykorzystuje technologię Avatar Cloud Engine (ACE) NVIDIA, podkreślając potencjał AI w realistycznym odwzorowywaniu animacji i mowy konwersacyjnej. Mimo że prezentacja skupiła się na wybranych fragmentach, a reakcje NPC mogły wydawać się nieco mechaniczne, to samo przedsięwzięcie otwiera nowe perspektywy dla branży gier. NVIDIA i Inworld AI mają nadzieję, że udostępnienie kodu źródłowego „Covert Protocol” zachęci deweloperów do eksploracji technologii cyfrowego człowieka, potencjalnie zmieniając sposób tworzenia i interakcji z postaciami w grach. Co więcej, demonstracje technologii Audio2Face w grach „World of Jade Dynasty” i „Unawake” ukazują, jak AI może ułatwić tworzenie animacji postaci w różnych językach, otwierając nowe możliwości dla globalnej dystrybucji i dostępności gier.